Virtualisierung

Mehr Flexibilität und Agilität bei der Ressourcennutzung

Der Siegeszug des Cloud Computing ist ohne Virtualisierung nicht denkbar, schließlich ist die Abstraktion von Hardware und Software und deren flexible Bereitstellung ein Schlüsselmerkmal aller „As-a-Service“-Modelle. Es ist daher kein Wunder, dass die Nachfrage nach Virtualisierungslösungen stark zunimmt. Der Gesamtmarkt soll Marktforschern zufolge bis 2026 von rund 40 Milliarden Euro auf rund 150 Milliarden Euro steigen – ein durchschnittlicher jährlicher Zuwachs von satten 25%.

Aber auch im klassischen Rechenzentrum hat die Virtualisierung längst Einzug gehalten. Vor allem Server werden meist als virtuelle Maschinen und nur noch in Ausnahmefällen direkt als physische Hardware zur Verfügung gestellt. Auch die Virtualisierung von Network Solutions, Data Storage und Applikationen sowie die Desktop-Virtualisierung nehmen immer mehr zu.

Was versteht man unter dem Begriff Virtualisierung?

Bei der Virtualisierung greifen Anwender, Betriebssysteme oder Applikationen nicht direkt auf Hardware und Software zu, sondern nutzen dazu eine Abstraktionsschicht. Diese übersetzt die Eingaben und verteilt sie möglichst optimal auf die vorhandenen Ressourcen.

Möglich macht dies ein sogenannter Hypervisor. Er vermittelt zwischen dem Wirtssystem (Host) und dem Gastsystem. Dafür emuliert er die Ressourcen so, dass sie für den Gast wie physikalische Hardware oder „normale“ Software erscheinen. Am Gastsystem selbst müssen deshalb keine Änderungen vorgenommen werden. Es funktioniert genau so wie in einem nicht-virtualisierten Umfeld.

Welche Arten der Virtualisierung gibt es?

Prinzipiell lassen sich bei der Virtualisierung folgende Arten unterscheiden:

Servervirtualisierung: Die bekannteste und am weitesten verbreitete Form der Virtualisierung ist die Servervirtualisierung. Dabei wird ein physikalischer Server auf mehrere virtuelle Maschinen (VM) aufgeteilt. Der Hypervisor übernimmt die Vermittlung zwischen den auf den virtuellen Servern laufenden Betriebssystemen und Applikationen auf der einen und Hardwarekomponenten wie Hauptprozessor (CPU), Arbeitsspeicher (RAM) und Data Storage auf der anderen Seite.

Netzwerkvirtualisierung: Bei der Netzwerkvirtualisierung steuert eine Softwareebene (Control Plane) das Netzwerkmanagement, während die Router und Switches nur noch für die Übertragung der Daten (Data Plane) zuständig sind. Die Virtualisierung der Netzwerkfunktion erleichtert die Netzwerkautomatisierung und Netzwerksegmentierung erheblich, da Zonierungs- und Verfügbarkeitskonzepte über die Softwareebenen definiert und ausgerollt werden können – und nicht mehr in die Firmware der Netzwerkgeräte integriert werden müssen.

Speichervirtualisierung: Wie Netzwerkgeräte lassen sich auch Speichersysteme abstrahiert von den physikalisch vorhandenen Festplatten oder SSDs als virtuelle Speicher zur Verfügung stellen. Ein Storage-Hypervisor vermittelt dabei zwischen den Anfragen und den in einem virtualisierten Speicherpool zusammengefassten Storage-Systemen.

Betriebssystemvirtualisierung: Bei der Betriebssystemvirtualisierung nutzen alle virtuellen Maschinen dieselben Systemressourcen. Nur die individuellen VM-Daten werden separat abgelegt. Die virtuellen Maschinen benötigen deshalb wesentlich weniger Platz als bei der vollständigen Servervirtualisierung, bei der jede VM ihr eigenes Betriebssystem mitbringt.

Anwendungsvirtualisierung: Bei dieser Form der Virtualisierung stellt die Vermittlerschicht Applikationen einer vom Betriebssystem abstrahierten Laufzeitumgebung zur Verfügung. Sämtliche Anwendungsprozesse werden in einer ausführbaren Datei gespeichert, so dass die Applikation sehr einfach von einem System auf ein anderes migriert werden kann.

Desktopvirtualisierung: Neben Servern lassen sich auch Clients (Desktops) aus einer virtualisierten Infrastruktur (Virtual Desktop Infrastructure, VDI) bereitstellen. Die Anwender greifen dabei mit einem Thin Client, über einen Browser oder über spezielle Applikationen auf ihre Desktop-Umgebung zu, die zentral im Rechenzentrum oder in einer Cloud-Umgebung gehostet wird.

Datenvirtualisierung: Bei der Datenvirtualisierung werden Informationen verschiedener Quellen und Formate so aufbereitet, dass sie ohne zusätzlichen physikalischen Data Storage analysiert werden können. Datenvirtualisierung kann als Alternative zu einem Data Warehouse oder zu ETL-Prozessen (Extract Transform Load) betrachtet werden, bei denen die Daten aus dem Quellsystem extrahiert, normalisiert und in ein Zielsystem geladen werden müssen.

Wie funktioniert Virtualisierung?

Virtualisierung bildet die physikalischen und logischen Bedingungen in den Host-Systemen als Emulation nach. Für das über der Abstraktionsschicht liegende System ist dieser Vorgang vollkommen transparent. Der Anwendende, das Betriebssystem oder die Applikation agiert jeweils ganz so, als ob direkt auf die Ressourcen zugegriffen würde. Es müssen daher keine Anpassungen vorgenommen werden.

Der Vermittler (Hypervisor) zwischen Wirts- und Gastsystemen sorgt dabei dafür, dass jedem System zur Laufzeit ausreichend Ressourcen zur Verfügung gestellt werden. In einigen Fällen kann es allerdings zu Leistungseinbrüchen kommen, so zum Beispiel beim gefürchteten „Boot Storm“ zu Arbeitsbeginn in einer virtualisierten Desktop-Umgebung.

Was sind die Vorteile der Virtualisierung?

Für die Virtualisierung sprechen vor allem folgende Gründe:

Optimale Auslastung von Hard- und Software: Physikalische Server und Desktops sind für eine Last ausgelegt, die nur sehr selten abgerufen wird. In der restlichen Zeit liegen große Teile der Ressourcen brach. Durch die Virtualisierung lassen sich diese Leistungsreserven sehr viel besser nutzen, da sie auf andere Systeme verteilt werden können.

Unternehmen, die Servervirtualisierung oder Desktopvirtualisierung einsetzen, können daher mit weniger Hardware und Software dieselbe Leistung erzielen. Das schont nicht nur die Budgets, sondern hat im Sinne von Green IT auch positive Auswirkungen auf den Energie- und Ressourcenverbrauch.

Einfachere Skalierbarkeit: Virtualisierte Server, Data Storage-Systeme und Netzwerke lassen sich erweitern, ohne dass oberhalb der Abstraktionsschicht Änderungen in der IT-Infrastruktur notwendig wären. In der Regel erkennt der Hypervisor automatisch, wenn zusätzliche Hardware zur Verfügung gestellt wird, und bindet sie in den Ressourcenpool ein.

Unsere Referenzen

Alle ansehen

Workplace

alma GmbH: Modern Workplace als Erfolgsrezept für die Marktexpansion

Data Center

ASOS: Versandriese modernisiert Berliner Logistikzentrum mit netgo und Ingram Micro

Data Center, IT-Services

Augenklinik Ahaus: Flexibel skalieren mit HPE GreenLake

Data Center, IT-Services, Workplace

Autohaus am Tannenkamp: Mit netgo freie Fahrt fürs Geschäft

Cloud, Security, IT-Services

Autoteile Klostermann: Die netgo cloud als Retter in der Not

Data Center, Workplace, Network

Beta Systems: Standortübergreifendes WLAN mit netgo

IT-Services

Carcoustics: Doppelt sparen und Freiraum gewinnen dank automatisierter Beschaffung

IT-Services, Workplace

commehr, coachhub und netgo group: Drei Unternehmen, zwei Herausforderungen und zwei Lösungen

IT-Services, Workplace

Coroplast: Coroplast setzt auf Microsoft Teams

Workplace

Coroplast: Mehrsprachiges Intranet via SharePoint Online für Coroplast

IT-Services

Delimon: Dank Servicepartnerschaft läuft es wie geschmiert

IT-Services

ESL Gaming: Optimierte IT-Beschaffung fördert schnelles, weltweites Wachstum

Data Center, Network

GIT net: Mit intelligentem Speicher und vereinfachter Administration Freiraum für die Digitalisierung schaffen

Cloud, Workplace

Hilltop Consulting: Cloud-Telefonie als Wachstumsgenerator

Data Center

HJK Erkelenz: Mikro-Rechenzentren im klinischen Datenbetrieb

IT-Services

Hochland: Mit dem Self-Service-Portal Prozesse optimieren, die Qualität erhöhen und die Zufriedenheit steigern

Data Center

Hoffnungstaler Stiftung Lobetal: Hyperkonvergenz spart Ressourcen und schafft Freiraum für Wachstum

Cloud, IT-Services, Workplace

Landschaftsbau Vornholt: Risikominimierung dank Cloud

Cloud, IT-Services, Workplace

Lapmaster Wolters: Mit netgo und M365 in die Cloud

Data Center, IT-Services

Lemken: Mit modularer Server-Infrastruktur die IT zukunftsfähig gemacht

Cloud, Workplace

Mehr-BB Entertainment: Veranstalter performt jetzt in der Cloud

Cloud, IT-Services

meinemarkenmode: IT als Service ebnet den Weg für schnelles Wachstum

Workplace

mobene: Modernes Intranet mit SharePoint Online

Cloud, Software

mobene: Process Excellence Platform mpmX als Sprungbrett in neue Märkte

IT-Services, Workplace, Software

Nintendo of Europe: Arbeitsabläufe automatisieren und Produktivitätspotenziale entfalten

Data Center, IT-Services, Software

office on: Wirtschaftlich wachsen mit skalierbarem Bezugsmodell

Workplace

Paracelsus Kliniken: Digitalisierte Serviceprozesse als Treiber für Kosteneffizienz und Kundenzufriedenheit

IT-Services, Workplace

Party Rent Group: Gefragtes Duo für besondere Ansprüche

Cloud, Security, IT-Services

Permadental: Backup in der netgo cloud für die IT-Security

IT-Services

Rittal: Partnerschaftlich (fast) Unmögliches möglich machen

Data Center

ROSE Bikes: Mit netgo auf der Ideallinie

Data Center, Network

ROSE Versand: WLAN für hundertprozentig sichere Echtzeitkommissionierung

Workplace

SANHA: Gerätemanagement leicht gemacht

Data Center, Security, IT-Services

Sommerlad: Wie den Schaden nach Hackerangriff minimieren und daraus lernen?

Workplace

Systea GmbH: Sprung zum Modern Workplace

IT-Services

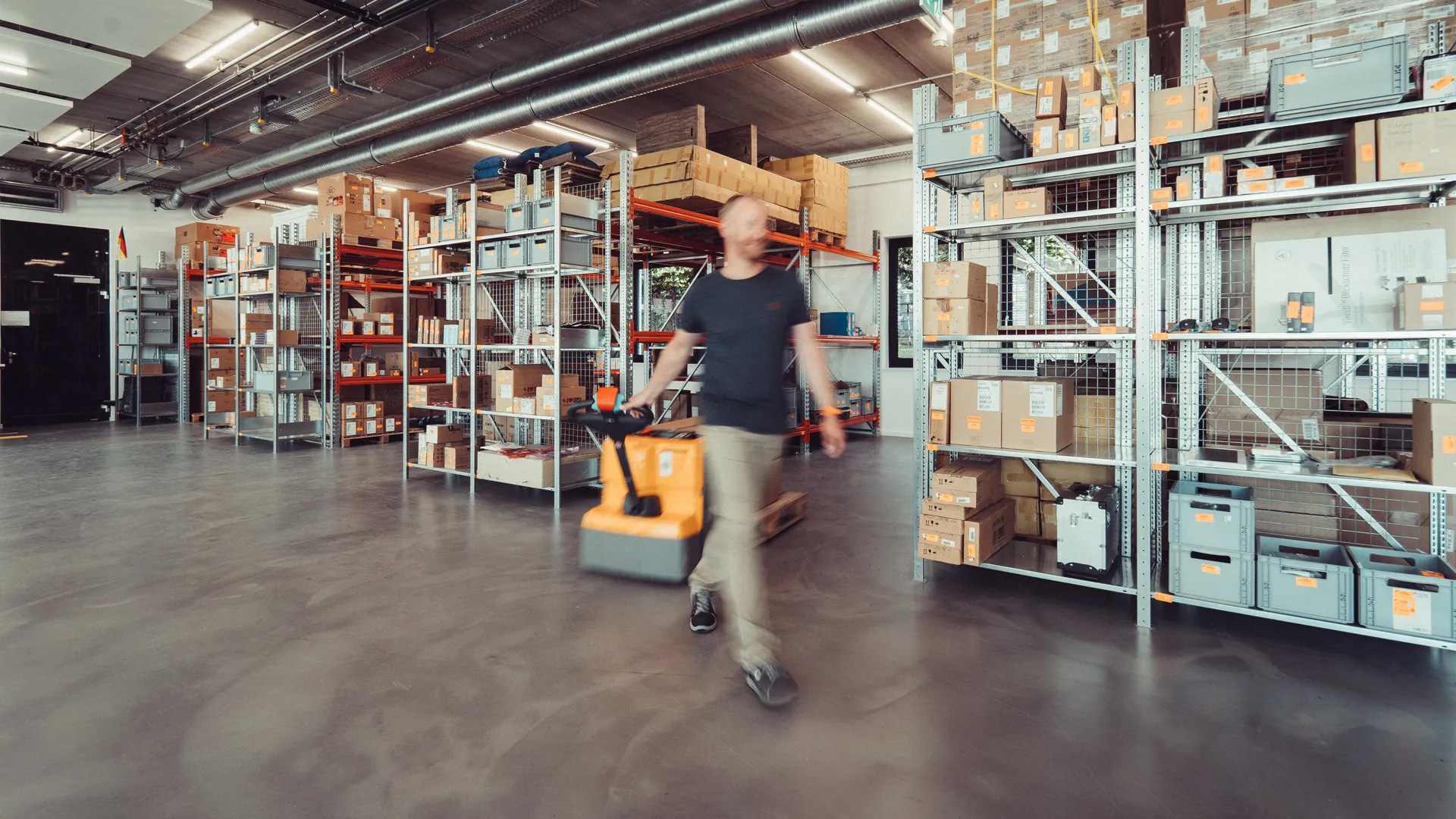

Trek Bicycle: Hardware und Services für reibungslose Store-Eröffnung in ganz Europa

Data Center, Workplace

Vossko: Neue IT-Infrastruktur stützt starkes Wachstum

Cloud, Workplace

Windpark Hollich: Frischer Wind durch flexible Zusammenarbeit in der Cloud

Apologies, we weren't able to find any results that match your search query.

Welche Risiken birgt Virtualisierung?

Bei der Virtualisierung können vor allem folgende Risiken auftreten:

Erhöhtes Ausfallrisiko: Bei der Server- und Desktopvirtualisierung werden viele virtuelle Maschinen auf einer einzigen Hardware-Plattform zur Verfügung gestellt. Kommt es bei einer physikalischen Maschine zu einem Problem, sind davon viele virtuelle Instanzen betroffen. Noch gravierender sind die Auswirkungen, wenn der Hypervisor selbst ausfällt, da dann alle von ihm verwalteten Ressourcen nicht mehr verfügbar sind.

Zusätzlicher Managementaufwand: Eine berühmt-berüchtigte Folge der Virtualisierung ist der sogenannte Server Sprawl. Weil virtuelle Maschinen sehr einfach aufzusetzen sind, kommt es zu einer Schwemme neuer Instanzen. Statt das IT-Service Management zu vereinfachen, müssen Administrierende plötzlich zusätzlich Unmengen an Servern oder Desktops verwalten.

Vergrößerte Angriffsfläche: Virtuelle Maschinen und Instanzen sind letztendlich Datenobjekte. Sie können daher leichter infiltriert, kompromittiert und gestohlen werden als physische Hardware oder dedizierte Software. Häufig kommt es aufgrund der schieren Masse an virtuellen Maschinen auch zu Konfigurationsfehlern, die zum Beispiel dazu führen, dass Server von außen über das Internet zugänglich sind. Laut dem Cyber Signal Report 2022 von Microsoft sind an 80 Prozent erfolgreicher Ransomware-Attacken Konfigurationsfehler beteiligt.

Gefahr von Lizenzverstößen: Betriebssysteme und Anwendungssoftware werden häufig hostbasiert lizenziert, das heißt sie dürfen nur auf einem Rechner oder einer bestimmten Zahl von Prozessoren beziehungsweise Prozessorkernen betrieben werden. Ob diese Basis virtualisiert werden darf und welche Kosten dabei entstehen, steht im Kleingedruckten der Lizenzvereinbarung.

Wer diese Informationen ignoriert, riskiert Compliance-Verstöße und bei einem Audit unter Umständen hohe Nachforderungen durch den Softwarehersteller. Auf jeden Fall benötigen Unternehmen, die virtualisieren, ein leistungsfähiges Software Asset Management, das alle Lizenzfallen berücksichtigt.

Praxistipps zur Virtualisierung in Unternehmen

Unternehmen sollten die Komplexität und den Aufwand von Virtualisierungsprojekten nicht unterschätzen und bei der Umsetzung einer Virtualisierungsstrategie überlegt vorgehen. Dabei sind folgende Schritte zu beachten:

- Erfassung der vorhandenen Ressourcen: Bevor entschieden werden kann, welches Virtualisierungspotenzial realisiert werden kann, muss zunächst einmal die Ist-Situation geklärt werden: Welche Hardware und Software ist im Einsatz? Wie ist der Auslastungsgrad? Welche Systeme könnten virtualisiert werden, welche nicht? Welche Lizenzen sind vorhanden und welche Folge hätte eine Virtualisierung auf die Lizenzkosten? Müssen neben der Virtualisierungssoftware weitere Tools angeschafft werden? Gibt es Alternativen zur Virtualisierung im eigenen Rechenzentrum, etwa die Migration in eine Cloud?

- Definition einer Migrationsstrategie: Im nächsten Schritt ist zu entscheiden, welche Hypervisor-Lösung eingesetzt werden soll und wie die vorhandenen Server, Desktops und Applikationen migriert werden können. Auch ein Redundanzkonzept sollte in dieser Phase entwickelt werden, um die Hochverfügbarkeit der virtualisierten IT-Infrastruktur sicherzustellen. Damit es nicht zu einer unkontrollierten Vermehrung virtueller Maschinen kommt, sollte außerdem von vornherein geklärt werden, wer unter welchen Bedingungen neue Instanzen aufsetzen darf.

- Umsetzung: Nach der Definition einer Strategie folgt deren Umsetzung. Unternehmen sollten dabei nicht einem starren Plan folgen. Das funktioniert in den komplexen und oft hybriden IT-Infrastrukturen der heutigen Zeit nicht mehr, zumal sich meist schon während des Projekts die Rahmenbedingungen ändern können. Viel wichtiger ist es, das Ziel nicht aus den Augen zu verlieren und den Erfolg der Virtualisierung anhand geeigneter Performance-Kennzahlen kontinuierlich zu messen.

- Absicherung und Management: Virtualisierung ist kein Projekt, sondern ein Prozess, der gemanagt werden muss. Besonderes Augenmerk sollten IT-Verantwortliche auf die Konfiguration der virtuellen Maschinen legen, da hier die größten Sicherheitsrisiken entstehen können.